En 1956, lors de la conférence de Dartmouth, les chercheurs ont posé deux hypothèses pour l’avenir de l’intelligence artificielle :

- d’un côté, l’IA symbolique, qui cherche à reproduire le raisonnement logique à travers des règles explicites ;

- de l’autre, une piste plus spéculative, inspirée du cerveau et de ses neurones.

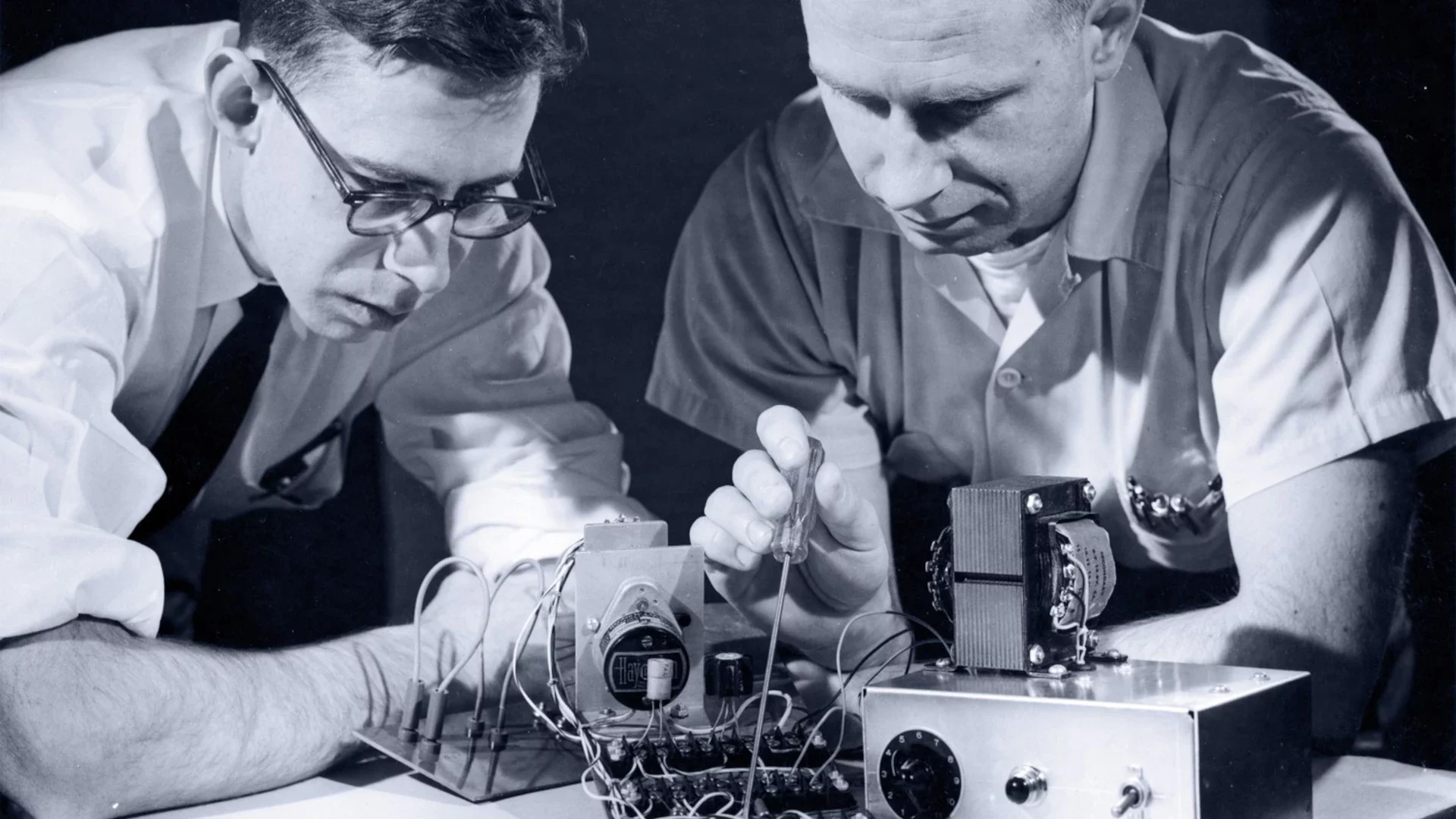

Un an plus tard, cette seconde voie prend forme. En 1957, Frank Rosenblatt, jeune psychologue au Cornell Aeronautical Laboratory, conçoit le perceptron, un modèle mathématique inspiré du neurone.

Le rêve d’un neurone artificiel

Le principe est simple : des données entrent, elles sont pondérées par des coefficients, puis produisent une sortie. Mais surtout, le perceptron peut ajuster ses coefficients en fonction des erreurs commises. Autrement dit, il apprend par expérience.

L’emballement des promesses

Ce qui fascinait, c’est que le perceptron semblait rompre avec la logique rigide des systèmes experts. Là où il fallait jusqu’ici coder chaque règle à la main, Rosenblatt proposait une machine qui, comme un enfant, apprendrait du monde en observant.

Les financements militaires affluent, certains prédisaient même que l’IA dépasserait l’humain en quelques décennies.

La machine qui distingue des formes

En 1958, Rosenblatt présente une machine équipée de capteurs optiques. Après quelques essais, elle parvient à distinguer des formes géométriques. C’est rudimentaire, mais inédit : pour la première fois, une machine apprend à partir de données, sans que toutes les règles soient codées à la main.

L’emballement médiatique

La presse s’empare du sujet. On prédit déjà des machines capables de marcher, traduire, parler, reconnaître des visages, écrire de la poésie. Les financements militaires affluent, et Rosenblatt lui-même annonce qu’un perceptron assez complexe pourrait un jour rivaliser avec le cerveau humain.

Les premières désillusions en vue

L’enthousiasme autour du perceptron est immense, mais il ne durera pas. Dès la fin des années 60, les critiques commencent à s’accumuler. Marvin Minsky et Seymour Papert demontreront en 1969, que le modèle de Rosenblatt est mathématiquement limité (il échoue sur des problèmes aussi élémentaires que la fonction XOR).

Ces limites techniques, combinées à la lenteur des ordinateurs de l’époque, vont alimenter une vague de scepticisme. Ce désenchantement n’explosera qu’au début des années 70, avec le rapport Lighthill et la réduction des financements. Mais déjà, les graines du premier hiver de l’IA sont semées.

Une idée qui marque encore

Bien sûr, le perceptron de Rosenblatt restera limité. Mais, il pose un jalon essentiel : l’idée que l’intelligence pourrait émerger de l’apprentissage automatique, plutôt que d’une logique entièrement programmée. C’est ce fil qui sera repris des décennies plus tard par les réseaux de neurones multicouches, puis par le deep learning, moteur des IA modernes.

De Rosenblatt à ChatGPT, les mêmes dynamiques se répètent : annonces spectaculaires, fascination du public, critiques d’experts, retour à la réalité… puis nouvelle percée.

Le perceptron a inauguré un rythme qui deviendra familier : dans l’IA, les illusions de progrès et les vraies percées avancent souvent main dans la main, au point qu’il est parfois difficile de distinguer l’une de l’autre.

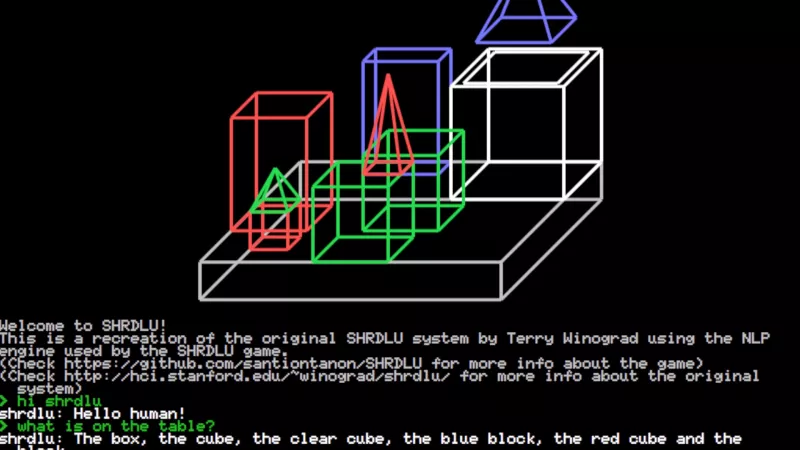

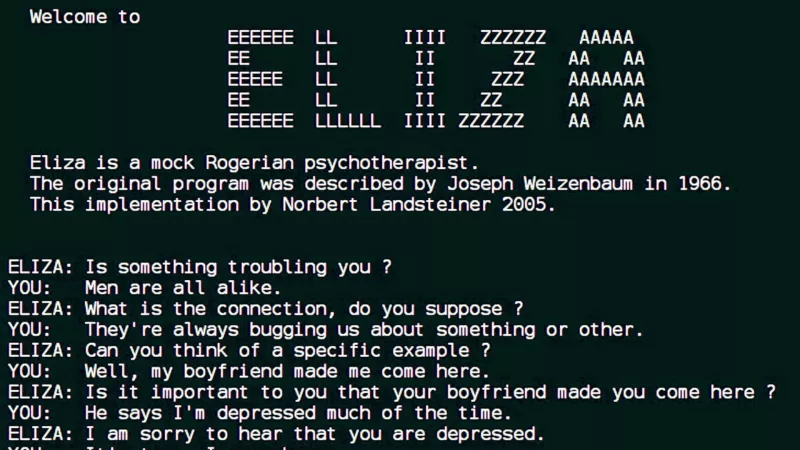

Mais l’IA ne s’écrivait pas que dans les neurones artificiels. Au MIT, dans les années 60, un programme qui parle du nom de ELIZA allait créer un autre choc.