Sommaire

Le machine learning transforme la façon dont les entreprises exploitent leurs données pour automatiser des décisions, prédire des tendances et optimiser leurs processus. Cette branche de l'intelligence artificielle permet aux systèmes d'apprendre automatiquement à partir d'exemples, sans programmation explicite de chaque règle métier.

Contrairement aux approches traditionnelles où les développeurs codent manuellement chaque condition, le machine learning identifie des patterns dans les données historiques pour généraliser à de nouvelles situations. Cette capacité d'adaptation automatique ouvre des perspectives considérables pour l'automatisation intelligente des tâches répétitives et l'aide à la décision stratégique.

Qu'est-ce que le machine learning ?

Principe de l'apprentissage statistique

Le machine learning repose sur l'identification de relations statistiques entre des variables d'entrée (features) et des variables de sortie (targets). Un algorithme analyse des milliers ou millions d'exemples pour découvrir des corrélations, des tendances et des structures cachées dans les données. Cette approche empirique contraste avec la programmation classique où chaque règle doit être explicitement définie.

Les modèles d'apprentissage automatique construisent une représentation mathématique des données d'entraînement, appelée fonction de prédiction ou fonction de décision. Cette fonction capture les patterns identifiés et permet de traiter de nouveaux cas similaires. La qualité de cette généralisation dépend fortement de la représentativité des données d'entraînement et de la complexité appropriée du modèle choisi.

Différence avec l'IA traditionnelle

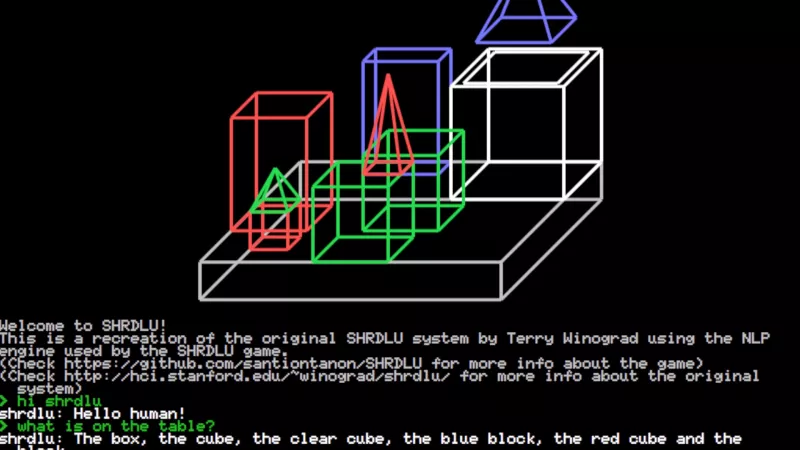

L'intelligence artificielle traditionnelle, aussi appelée IA symbolique, s'appuie sur des systèmes experts et des bases de règles codées manuellement par des experts métier. Ces systèmes excellent dans des domaines bien définis mais peinent à s'adapter à des situations non prévues.

Le machine learning adopte une approche inverse : au lieu de programmer des règles, on fournit des exemples et l'algorithme induit les règles automatiquement. Cette flexibilité permet de traiter des problèmes complexes où il serait impossible ou trop coûteux de définir manuellement toutes les conditions possibles. Les modèles peuvent également s'améliorer continuellement avec l'arrivée de nouvelles données, contrairement aux systèmes experts figés.

Cette capacité d'apprentissage continu représente un avantage décisif pour les entreprises évoluant dans des environnements dynamiques où les patterns changent régulièrement.

Écosystème d'outils et frameworks

L'écosystème machine learning s'articule autour de langages comme Python, R et Scala, qui offrent des bibliothèques spécialisées pour chaque étape du pipeline. Les frameworks populaires incluent scikit-learn pour l'apprentissage classique, TensorFlow et PyTorch pour le deep learning, et Apache Spark pour le traitement distribué de gros volumes.

Les plateformes cloud proposent des services managés qui simplifient le déploiement et la scalabilité des modèles. AWS SageMaker, Google AI Platform et Azure Machine Learning automatisent de nombreuses tâches techniques comme la gestion des ressources de calcul, le versioning des modèles et le monitoring en production. Ces outils démocratisent l'accès au machine learning pour les équipes sans expertise approfondie en infrastructure.

Types d'apprentissage automatique

Apprentissage supervisé

L'apprentissage supervisé utilise des données étiquetées où chaque exemple d'entraînement est associé à la réponse attendue. Cette approche couvre deux grandes familles de problèmes : la classification pour prédire des catégories (spam ou non-spam, client à risque ou solvable) et la régression pour estimer des valeurs numériques continues (prix immobilier, chiffre d'affaires prévisionnel).

Les algorithmes supervisés populaires incluent les forêts aléatoires, les machines à vecteurs de support (SVM), les régressions logistiques et les réseaux de neurones. Chacun présente des avantages spécifiques selon la nature des données et la complexité du problème. La prédiction supervisée nécessite un historique conséquent de cas résolus pour entraîner efficacement le modèle.

Apprentissage non supervisé

L'apprentissage non supervisé explore des données sans étiquettes pour découvrir des structures cachées ou des groupes naturels. Cette famille d'algorithmes excelle dans l'analyse exploratoire et la compréhension de phénomènes complexes où aucune variable cible n'est définie a priori.

La segmentation et le clustering constituent les applications principales de cette approche. Les algorithmes comme k-means, DBSCAN ou les modèles de mélange gaussien identifient des segments de clients, des profils de comportement ou des anomalies dans les données. Ces insights permettent de personnaliser les stratégies marketing, d'optimiser les processus opérationnels ou de détecter des fraudes.

La réduction de dimensionnalité, autre technique non supervisée, simplifie des jeux de données complexes en préservant l'information essentielle. Cette compression facilite la visualisation et accélère les traitements ultérieurs.

Apprentissage par renforcement

L'apprentissage par renforcement modélise des agents qui apprennent à prendre des décisions optimales dans un environnement dynamique. L'agent reçoit des récompenses ou des pénalités selon la qualité de ses actions, et ajuste progressivement sa stratégie pour maximiser sa performance à long terme.

Cette approche convient particulièrement aux problèmes séquentiels où les décisions s'influencent mutuellement dans le temps. Les applications incluent l'optimisation de portefeuilles financiers, la gestion automatisée de campagnes publicitaires, la planification de maintenance prédictive ou l'allocation dynamique de ressources informatiques. L'apprentissage par renforcement nécessite généralement plus de temps et de ressources computationnelles que les autres paradigmes, mais peut découvrir des stratégies sophistiquées inaccessibles aux approches traditionnelles.

Applications en entreprise

Automatisation des processus métier

Le machine learning automatise des tâches cognitives complexes qui nécessitaient auparavant l'intervention humaine. La classification automatique de documents, l'extraction d'informations structurées depuis des formulaires ou la catégorisation de tickets de support transforment l'efficacité opérationnelle. Ces applications réduisent les erreurs manuelles et libèrent du temps pour des activités à plus forte valeur ajoutée.

L'analyse de sentiment sur les retours clients, la détection automatique de fraudes dans les transactions financières ou l'évaluation de risques de crédit illustrent la capacité du machine learning à traiter des volumes importants avec une cohérence impossible à maintenir manuellement. L'intégration avec des outils d'automatisation comme n8n permet de créer des workflows intelligents qui s'adaptent aux contextes métier.

Optimisation marketing et ventes

Les modèles prédictifs révolutionnent la personnalisation marketing en analysant les comportements passés pour anticiper les préférences futures. La segmentation comportementale identifie des groupes de clients homogènes pour adapter les messages, les canaux de communication et les offres promotionnelles. Cette approche data-driven améliore significativement les taux de conversion et la satisfaction client.

Le scoring de leads automatise la qualification commerciale en évaluant la probabilité de conversion de chaque prospect. Les équipes de vente peuvent ainsi prioriser leurs efforts sur les opportunités les plus prometteuses. La prédiction de churn (attrition client) permet d'identifier proactivement les clients à risque de départ pour déclencher des actions de rétention ciblées.

L'optimisation des prix dynamiques, basée sur l'analyse de la demande, de la concurrence et des stocks, maximise la rentabilité tout en préservant la compétitivité. Ces applications nécessitent une qualité des données irréprochable pour éviter des décisions contre-productives.

Maintenance prédictive et opérations

La maintenance prédictive analyse les données de capteurs IoT pour anticiper les pannes d'équipements avant qu'elles ne surviennent. Cette approche proactive réduit les coûts de maintenance, minimise les arrêts de production non planifiés et prolonge la durée de vie des actifs industriels.

La détection d'anomalies surveille en continu les métriques opérationnelles pour identifier des comportements inhabituels. Cette surveillance automatisée s'avère particulièrement précieuse pour les systèmes critiques où une défaillance peut avoir des conséquences importantes sur la continuité d'activité. L'intégration avec des systèmes d'alerte permet une réaction rapide aux incidents potentiels.

Données, qualité et preprocessing

Collecte et préparation des données

La réussite d'un projet machine learning dépend avant tout de la qualité et de la pertinence des données utilisées. La phase de collecte nécessite d'identifier toutes les sources de données internes et externes susceptibles d'apporter de la valeur prédictive. Cette démarche implique souvent de croiser des systèmes hétérogènes : CRM, ERP, logs applicatifs, données externes ou APIs tierces.

L'intégration de ces sources disparates représente un défi technique et organisationnel majeur. Les processus ETL (Extract, Transform, Load) doivent être robustes pour gérer les différences de formats, de fréquences de mise à jour et de qualité entre les systèmes. La mise en place d'une architecture de données cohérente, idéalement autour d'un Single Source of Truth, facilite grandement les projets ultérieurs.

La gouvernance des données devient cruciale pour maintenir la cohérence et la traçabilité des transformations appliquées. Chaque modification doit être documentée et versionnée pour permettre la reproductibilité des résultats et faciliter les audits de conformité.

Nettoyage et transformation

Le preprocessing consomme généralement 70 à 80% du temps d'un projet machine learning. Cette étape critique inclut la gestion des valeurs manquantes, la détection et le traitement des outliers, ainsi que la normalisation des données pour homogénéiser les échelles et les formats.

Les techniques de feature engineering créent de nouvelles variables à partir des données brutes pour améliorer la performance prédictive. Cette transformation peut inclure des agrégations temporelles (moyennes mobiles, tendances), des ratios métier ou des encodages spécifiques pour les variables catégorielles. L'expertise métier s'avère indispensable pour identifier les transformations les plus pertinentes.

Conformité et données personnelles

Les projets machine learning manipulent souvent des données personnelles soumises au RGPD et autres réglementations sur la protection des données. L'identification des données à caractère personnel (PII) et leur traitement approprié constituent des prérequis légaux incontournables. Les techniques de pseudonymisation, d'anonymisation ou de masquage doivent être appliquées selon les contextes d'usage.

La minimisation des données, principe fondamental du RGPD, impose de ne collecter et traiter que les informations strictement nécessaires aux objectifs définis. Cette contrainte influence directement la conception des modèles et peut nécessiter des arbitrages entre performance prédictive et conformité réglementaire. L'IA Act européen ajoute des exigences spécifiques sur la transparence et l'explicabilité des algorithmes dans certains secteurs.

Évaluation et performance des modèles

Métriques et validation

L'évaluation des modèles repose sur des métriques spécifiques au type de problème traité. Pour la classification, l'accuracy, la précision, le recall et le F1-score mesurent différents aspects de la performance prédictive. La matrice de confusion visualise les types d'erreurs commises et guide les optimisations ciblées.

La validation croisée (cross-validation) évalue la robustesse du modèle en testant sa performance sur plusieurs échantillons distincts. Cette technique détecte le surapprentissage (overfitting) où le modèle mémorise les données d'entraînement sans généraliser correctement. Le partitionnement train/validation/test doit respecter la distribution temporelle des données pour éviter les biais de sélection.

Les courbes ROC et AUC quantifient la capacité discriminante des modèles de classification binaire, tandis que les métriques comme le RMSE ou le MAE évaluent la précision des prédictions numériques en régression.

Interprétabilité et explicabilité

L'explicabilité des modèles devient un enjeu majeur, particulièrement dans les secteurs régulés où les décisions automatisées doivent être justifiables. Les modèles linéaires offrent une interprétabilité naturelle grâce à leurs coefficients, mais les algorithmes complexes comme les forêts aléatoires ou les réseaux de neurones nécessitent des techniques spécialisées.

SHAP (SHapley Additive exPlanations) et LIME (Local Interpretable Model-agnostic Explanations) calculent l'importance de chaque variable dans les prédictions individuelles. Ces outils permettent de comprendre pourquoi un modèle a pris une décision spécifique et d'identifier d'éventuels biais discriminatoires. L'analyse des feature importances globales révèle les variables les plus influentes sur l'ensemble du modèle.

Monitoring en production

Le déploiement en production nécessite un monitoring continu pour détecter la dégradation des performances au fil du temps. Le concept de drift désigne l'évolution naturelle des données qui peut rendre un modèle obsolète. Le data drift mesure les changements dans la distribution des variables d'entrée, tandis que le concept drift évalue l'évolution des relations entre variables.

L'observabilité des données surveille la qualité des inputs en temps réel : valeurs manquantes, outliers, changements de format ou de volume. Des alertes automatisées déclenchent des actions correctives avant que la dégradation n'impacte les utilisateurs finaux. La mise en place de tableaux de bord dédiés facilite le suivi des métriques clés par les équipes opérationnelles.

Mise en production et maintenance

MLOps et industrialisation

Le MLOps (Machine Learning Operations) adapte les pratiques DevOps aux spécificités du machine learning pour industrialiser le cycle de vie des modèles. Cette approche couvre le versioning des données et du code, l'automatisation des pipelines d'entraînement, les tests de régression et le déploiement continu. Les outils comme MLflow, Kubeflow ou DVC facilitent la gestion des expérimentations et la reproductibilité des résultats.

La conteneurisation avec Docker encapsule les modèles et leurs dépendances pour garantir la portabilité entre les environnements de développement, test et production. L'orchestration Kubernetes permet de gérer l'élasticité et la haute disponibilité des services de prédiction. Ces pratiques réduisent significativement les risques de déploiement et accélèrent la mise sur le marché des innovations.

Intégration avec les systèmes existants

L'intégration des modèles machine learning dans l'écosystème informatique existant nécessite une architecture bien pensée. Les API REST ou GraphQL exposent les fonctionnalités de prédiction aux applications métier de manière standardisée. La gestion des versions d'API permet de faire évoluer les modèles sans casser les intégrations existantes.

Les webhooks automatisent les déclenchements de prédictions suite à des événements métier spécifiques. Cette approche événementielle optimise les performances en évitant les appels inutiles et garantit la fraîcheur des prédictions. L'intégration avec des plateformes comme Make ou Zapier démocratise l'usage des modèles auprès des utilisateurs métier.

La gestion des erreurs et des fallbacks assure la continuité de service même en cas de défaillance des modèles. Les mécanismes de circuit breaker et de retry automatique maintiennent l'expérience utilisateur lors d'incidents temporaires.

Gouvernance des modèles

La gouvernance des modèles machine learning établit les processus de validation, d'approbation et de surveillance nécessaires à leur exploitation en production. Cette démarche définit les rôles et responsabilités de chaque acteur : data scientists, ingénieurs ML, experts métier et responsables conformité.

Le registre des modèles centralise la documentation technique et fonctionnelle de chaque algorithme déployé. Cette traçabilité facilite les audits réglementaires et permet de mesurer l'impact business des initiatives machine learning. Les SLA et SLO définissent les niveaux de service attendus en termes de disponibilité, latence et précision des prédictions.

- La validation des modèles par des experts métier garantit la cohérence avec les règles business et détecte les biais potentiels avant la mise en production.

- Les processus de retrain automatisé maintiennent la performance des modèles face à l'évolution des données, avec des seuils de déclenchement basés sur les métriques de drift.

- L'archivage et la sauvegarde des versions de modèles permettent de revenir rapidement à une version stable en cas de régression de performance.

- La documentation des décisions d'architecture et des compromis techniques facilite la maintenance et l'évolution des systèmes par de nouvelles équipes.

FAQ

Quelle différence entre machine learning et intelligence artificielle ?

L'intelligence artificielle est un domaine plus large qui englobe toutes les techniques permettant aux machines de simuler l'intelligence humaine. Le machine learning est une sous-branche de l'IA qui se concentre spécifiquement sur l'apprentissage automatique à partir de données, sans programmation explicite des règles.

Combien de données faut-il pour entraîner un modèle machine learning ?

Le volume de données nécessaire dépend de la complexité du problème et de l'algorithme choisi. Pour des tâches simples, quelques milliers d'exemples peuvent suffire, tandis que les modèles complexes comme les réseaux de neurones profonds nécessitent souvent des millions d'échantillons. La qualité des données importe plus que la quantité brute.

Le machine learning peut-il remplacer complètement l'expertise humaine ?

Non, le machine learning complète l'expertise humaine plutôt qu'elle ne la remplace. Les experts métier restent indispensables pour définir les objectifs, interpréter les résultats, valider la cohérence des prédictions et gérer les cas d'exception. L'approche Human-in-the-loop combine efficacement l'automatisation et le jugement humain.